您现在的位置是:首页 > 芯片芯片

AI的「iPhone时刻」后,英伟达打开生成式模型「魔盒」

![]() cc博主2023-03-22【芯片】352人已围观

cc博主2023-03-22【芯片】352人已围观

在人工智能应用“淘金潮”的火热背后,总少不了“卖水工”英伟达的“默默付出”。

最近爆红的ChatGPT也离不逃脱不开这一定律。正如英伟达CEO黄仁勋在GTC演讲中展示的那样,数年以前,正是黄仁勋亲手将附有自己签名与赠语的全球首台DGX交给了OpenAI。

正因为这台集成了八块通过NVLink共享算力的H100组成的超级计算机,OpenAI才获得了向世界交出这份名为ChatGPT答卷的机会。

在英伟达向OpenAI交付首台DGX AI电脑后,位列《财富》100强的企业中有一半都使用了DGX AI计算机。英伟达的算力基础设备与人工智能应用,俨然已经成为了一枚硬币不可分割的正反面。

在刚刚结束的英伟达GTC 2023上,英伟达向我们展示了他们向人工智能的未来迈出的下一步。

人工智能的“iPhone时刻”

如今,生成式AI和大语言模型带来的杀手级应用在全球的火热,又让人工智能站到了一个新的路口前,如黄仁勋在GTC 2023的演讲中所说的一样,人工智能现在等来了属于自己的“iPhone时刻”。

而作为AI硬币另一面,英伟达也正随AI一同前行。

黄仁勋预测,就像iPhone带来智能手机和应用程序的普及一样,能生成自然文章和图像的“生成式AI”将在社会普及。

“算力即权力”这句口号正以人们未曾预料到的速度变为现实,但对于企业和开发者来说,想获得这样的“权力”并没有那么容易。

新生的初创公司竞相构建从未有过的产品的商业模式,老牌公司也在积极拥抱变化,应对新的环境。

而大模型的训练需要数据中心成百上千的计算卡“齐心协力”,对企业来说,这代表着场地和维护成本,是一道并不容易越过的门槛。

不论是新生血液还是老牌豪强,都呼唤更快捷的人工智能开发流程。

作为“算力供应商”的英伟达已经发觉了这一新需求,并推出了云端人工智能DGX Cloud。

DGX Cloud能够为客户提供专用的计算集群,每个DGX Cloud实例配备八个NVIDIA H100或A100 80GB Tensor Core GPU共640GB的GPU内存,用户能够按月租用这些计算资源,并使用简单的web浏览器访问。从而消除在本地获取、部署和管理基础设施的成本,大大增加了AI的便捷性。

对于这一产品的远景,黄仁勋充满憧憬的描绘到:“如今通过一个浏览器,就能将DGX AI超级计算机即时地接入每家公司。”

这样的愿景并非空中楼阁,在GTC 2023的演讲中,黄仁勋宣布,英伟达将与云服务提供商合作托管DGX云基础设施,目前已经于甲骨文达成了合作,甲骨文的OCI RDMA Supercluster已经提供了一个可扩展到超过32000个GPU的超级集群。微软Azure预计下个季度开始托管DGX Cloud,很快谷歌云也将加入托管的行列。

打开生成式AI的“魔盒”

iPhone问世之后,并没有止步不前,而是引领了智能手机长达数十年的大发展。如今走到“iPhone时刻”的AI,面对的也是一个与当年的iPhone极其相似的世界。

ChatGPT的成功,对AI的革命而言,仅仅是踏进门口的一小步。

门后的世界中,还蕴藏着属于生成式AI更广阔的世界。

在基础设施之外,对想要掌握AI“原力”的企业来说,如何搭上AI的下一班车,建立一个生成式AI模型,并将其应用到生产中,也将是一个重要命题。

英伟达发布的新云服务平台NVIDIA AI Foundations则是让企业做到这一点的“神兵利器”。

NVIDIA AI Foundations被分为用于构建定制的语言文本模型的Nemo、提供视觉语言制作服务的Picasso和提供医学相关数据专有模型构建服务的Bionemo三个而部分。

在Nemo中,客户可以引入自己的模型,或使用Nemo包含的从GPT-8、GPT-43到GPT-530等数十亿参数的预训练模型,并基于此构建自己掌控下的语言模型。

Picasso则为使用者提供了大量具有授权许可的专业图像和视屏素材,使用者能够使用这些许可内容或根据自己的专有内容训练自定义模型,并将生成的内容导入编辑工具,甚至可以导入英伟达元宇宙平台Omniverse,投入“元宇宙”的大基建事业。

能够提供包括语言、视觉和生物学等领域模型在内的制作服务,适用于需要构建、改进和操作自定义 LLM 的客户以及使用专有数据训练的生成 AI,以及针对特定领域的任务。

使用Bionemo,用户既能够即时访问药物研发工作流,也可以用于蛋白质结构预测和蛋白质生成与分子生成、分子对接等新药研究关键步骤的模型生成中。

英伟达不仅将三者合一的NVIDIA AI Foundations视为云服务,更将其视为构建生成式AI模型的“代工厂”。

GPU反客为主,造芯关键步骤“抢班夺权”

要想真正跨过AI下一次进化的大门,作为人工智能最重要的“基建设备”的GPU芯片本身的制造也极为重要。

人工智能的火热,离不开GPU的助力。能够提供大量执行重复简单计算的GPU对需要大量算力的大模型和神经网络来说,是天然的伴侣。

在过去的几年里,人工智能在掀起了在工业上落地的浪潮。小到餐厅中的小料台补货,大到码头或光伏电站,人工智能已经成为了工业领域公认的“先进产能”。

而在兜兜转转之后,GPU的发明者英伟达,终于把人工智能的触手带回了“最初的起点”——GPU芯片的制造上。

黄仁勋在演讲中提到,随着芯片制造工艺的进步,如今的芯片制造已经要求约一个金原子或一条人类DNA链尺寸的误差。

而作为芯片制造的核心步骤和起始阶段的光刻更是重中之重。

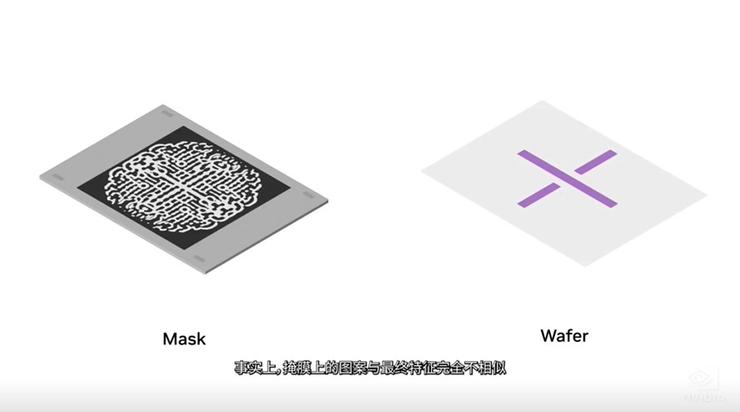

大约30年前,晶体管的尺寸已经发展到比光刻机波长更小,由于衍射效应,掩膜上的图案与最终图案特征变得完全不同,这使得模拟光通过光学元件和光刻胶互相作用结果的计算光刻成为了芯片制造过程中机器重要的一环。

此前,CPU一直是承担这一工作负载的主力。根据黄仁勋的估算,每年芯片制造商们在这一步骤上消耗了数百亿CPU小时的算力来创建用于光刻系统的掩模板。

但随着先进制程发展,计算光刻变得愈加复杂,CPU负载已经举步维艰。

多次高呼“摩尔定律已死”的英伟达CEO黄仁勋在今天的演讲上带来了人工智能与芯片制造结合的最新成果:基于用于芯片制造的NVIDIA cuLitho软件库,为芯片制造找到了一条新的“活路”。

英伟达表示,在cuLitho加持下,短期内可以提升芯片产业链效率,并大幅降低功耗,在新的流程下,仅需要500块H100就能够完成此前需要传统流程中40000个CPU系统才能完成的工作,让光刻技术性能跃升了40倍。

而相比现有的流程,使用cuLitho、能够仅使用如今九分之一的功耗做到每天三到五倍的生产效率,也能在一夜之间完成传统方法两周才能完成的单个掩模板处理任务。

而长远来看,英伟达则有着更远大的目标。

英伟达不仅将与台积电、新思科技合作,将NVIDIA cuLitho软件库集成到软件和系统中,用于制造最新一代的Hopper架构GPU。

黄仁勋还在演讲中宣布,英伟达将与台积电、阿斯麦与新思科技合作,并利用cuLitho为未来2nm及后续更先进制程芯片的制造打下基础。从而为AI“iPhone时刻”后的革命准备好充足“粮草”。雷峰网(公众号:雷峰网)

雷峰网原创文章,未经授权禁止转载。详情见转载须知。

Tags:

相关文章

- FreeYond开启东南亚征程,登陆马来西亚

- 长期免费ssr节点账号分享-v2ray节点机场每日更新(2023/3/21)

- 李开复宣布筹组中文版 ChatGPT 公司“Project AI 2.0”

- ChatGPT API 正式发布,中国厂商往何处去?

- 中国电商霸榜西班牙购物App前三,阿里占了俩

- 2022年度腾讯研发数据公布:每四个腾讯员工中就有三个从事研发

- 最新VPN节点免费ssr节点分享-v2ray免费机场订阅地址-24小时更新(2023/3/20)

- 华为Mate X3有多强?余承东:极致轻薄引领用户体验

- 网曝特斯拉被要求降低中国员工工资,从1.3万降到5341元;任正非称进华为不能只看工资高;李开复宣布加入中文版ChatGPT大战丨雷峰早报

- 爱用云计算:免费领取美国虚拟空间,免费领取美国云服务器,免备案香港/美国云服务器1核1G13.9元/月 2核2G 17.9元/月 4核4G 21.9元/月,香港/美国独立物理机350元/月,福利机器来一波!!24小时在线客服秒回复