您现在的位置是:首页 > 人工智能人工智能

DeepMind最新研究:如何将「大语言模型」 训练到最优?

![]() cc博主2022-04-11【人工智能】597人已围观

cc博主2022-04-11【人工智能】597人已围观

Transformer的提出距离我们已经有5年的时间,随着模型规模的不断增长,性能提升也逐渐出现边际效益递减的情况。如何训练出最优性能的大模型?

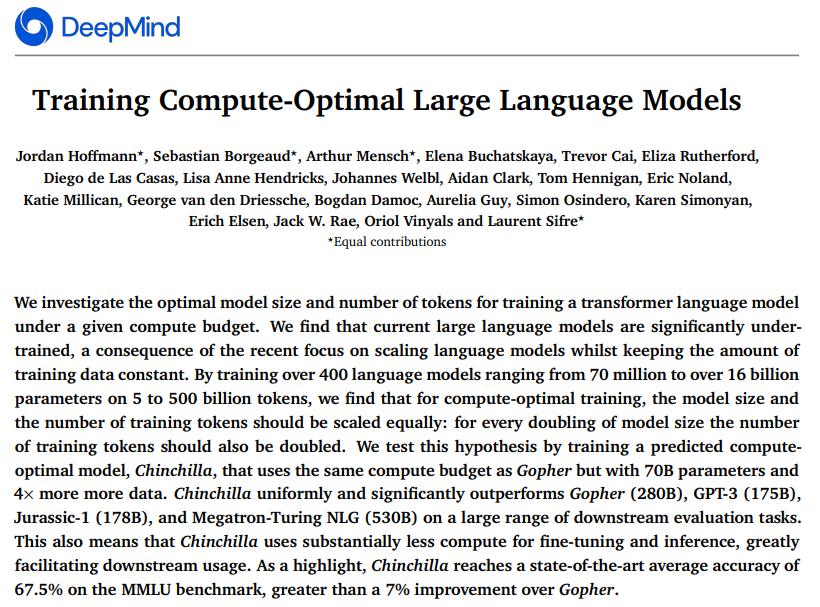

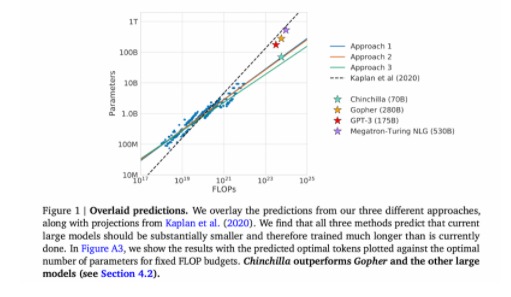

最近,DeepMind做了一项调查,想弄清AI语言模型的规模和token之间的关系。这个小组训练了超过400个模型,规模从7000万参数到160亿参数不等,token数量从50亿到5000亿不等。

该小组发现,模型参数大小和token的数量成正相关,换句话说,当模型规模加倍的时候,token也应该加倍。

如何得到这种关系?

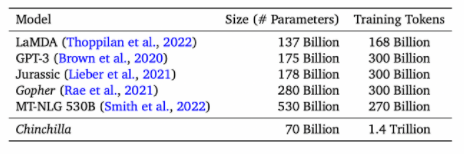

目前确实是大模型时代,自从1750亿参数的GPT-3横空出世时,勾起了研究员的兴趣。近两年的时间,业界陆续推出了好几个模型,且一个比一个大,并且在多数任务上获得了令人令人深刻的性能。

但这种超越认知的性能表现,是以巨大的计算和能源消耗为代价,业界也一直在讨论这种代价是否值得。例如前谷歌研究员Timnit Gebru就曾撰写论文讨论“AI 语言模型是否太大以及科技公司在降低潜在风险方面做得是否足够。”她也因为该论文被谷歌解雇。

大模型的训练预算一般是提前计划好的,毕竟训练一次成本太大。因此,在给定预算的条件下,准确估计最佳模型超参数变得非常关键。之前,也有学者已经证明参数的数量和自回归语言模型(autoregressive language model)的性能之间存在幂律关系。

例如先前的研究表明,10倍计算预算对应增加5.5倍模型规模,以及1.8倍的token数量。但这项研究表明:模型大小和token的数量应该成等比例增长。

此外,研究员还预测,对于训练Gopher(2800亿个参数的语言模型),最佳模型应该小4倍,并且应该在大4倍的token上进行训练。这一预测,在包含1.4万亿个token的 Chinchilla中的训练得到验证。Chincilla的性能优于Gopher,由于模型规模减小,推理成本也更低。

如何让大模型更加高效?

大模型只有在大数据集上才能发挥最大的效力,同时,DeepMind也注意到,处理大数据集时需要格外小心,训练集和测试集的合理划分,才能最小化语言建模损失以及最优赋能下游任务。

研究界必须考虑与此类大型模型相关的伦理和隐私问题。正如过去所讨论:从网络上收集的大型数据集包含有毒的语言、偏见和私人信息。

关于大模型如何更高效的问题,近日,清华大学刘知远从模型架构层面也提出了看法《清华刘知远:大模型「十问」,寻找新范式下的研究方向》,他表示:

随着大模型越变越大,对计算和存储成本的消耗自然也越来越大。最近有人提出GreenAI的概念,即需要考虑计算能耗的情况来综合设计和训练人工智能模型。面向这个问题,我们认为,随着模型变大,AI会越来越需要跟计算机系统进行结合,从而提出一个更高效面向大模型的支持体系。一方面,我们需要去建设更加高效分布式训练的算法,在这方面国内外都有非常多的相关探索,包括国际上比较有名的DeepSpeed 以及悟道团队在开发的一些加速算法。

另一个方面,大模型一旦训练好去使用时,模型的“大”会让推理过程变得十分缓慢,因此另外一个前沿方向就是如何高效将模型进行尽可能的压缩,在加速推理的同时保持它的效果。这方面的主要技术路线包括剪枝、蒸馏、量化等等。同时最近我们发现,大模型里面具有非常强的稀疏发放的现象,这对于模型的高效压缩和计算有着非常大的帮助,这方面需要一些专门算法的支持。

雷峰网(公众号:雷峰网)

雷峰网版权文章,未经授权禁止转载。详情见转载须知。

Tags:ss免费节点

相关文章

- 牛津大学最新调研:AI面临基准危机,NLP集中“攻关”推理测试

- 最新免费SSR节点账号分享-永久v2ray节点-周末福利(2022/4/10)

- 香港CN2宿主机 E5 2650V2*2256G20M 2000元/月香港云服务器2H2G10M29.9元/月90IDC

- 德国回程CN2云服务器 2核 2G20M 66元/月 青叶云

- 分享如何翻墙浏览Google、Youtube、Facebook及Twitter网站的方法

- 美国洛杉矶CN2云服务器1核1G10M 17.5元/月 -免费体验15天-满意付款,特殊防御可以定制XOVV

- 彻底分家?传Arm为上市转让全部安谋股份

- 共创显示次时代,思谋打造 Mini LED 智能检测

- 腾讯总裁刘炽平年薪3.2亿,同比下降,马化腾年薪降25%;曝喜茶创始人2.7亿接盘许家印深圳湾豪宅;淘宝支持修改账号名|雷峰早报

- 永久免费v2ray节点链接分享-SSR节点账号分享-每日更新(2022/4/8)

猜你喜欢

软银抛售阿里大半持股融资,董事会席位或不保;国美大幅裁员,多位高管被免职;金融业限薪令出台,控制薪酬差距,向一线员工倾斜|雷峰早报

业界

国美大幅裁员,多位高管被免职8月3日消息,据财新网报道,多名国美员工表示,公司在4月开启一轮裁员,涉及3C、家电等多个部门,作为战略重点的电商平台真快乐亦未能幸免。内部人士称,真快乐公司执行副总裁丁薇已被免职,团队已大幅裁员。不仅如此,国美多个业务板块均有人...

阅读更多SpaceX 前退休CTO Tom Mueller:虽然退休了,我还是想上火星

人工智能

他提出首个商业火星任务,要和马斯克拼速度。作者 | 王玥编辑 | 陈彩娴Tom Mueller,现年61岁,世界顶级火箭推进专家。但他自称为赛车手,因为他退休时说自己想去「玩玩赛车、骑越野自行车、旅旅游什么的」。而在退休前,Mueller是Space X...

阅读更多刘仁辰,陈恂就任安谋科技联席CEO,吴雄昂出局

芯片

安谋科技(中国)有限公司于今日早些时候宣布其董事会依据公司章程及相关法律规定已经通过决议,一致同意聘任刘仁辰与陈恂担任安谋中国联席首席执行官,并依法完成工商登记。根据资料显示,自4月28日起,安谋科技法定代表人已经变更为刘仁辰。雷峰网(公众号:雷峰网)安谋...

阅读更多京东收购德邦后,外部收入将会提升,亏损是否能迎来逆转?

业界

雷峰网(公众号:雷峰网)消息,3月2日,据《新言财经》报道,京东已经完成对德邦快递的收购。对此京东方面暂未回应,德邦回应称一切以公告为准。关于德邦快递被收购的消息,市场上一直传得沸沸洋洋。早在今年1月6日,就有京东收购德邦的消息在坊间流传。近日,网络流...

阅读更多助力跨境电商出海 腾讯云推出“轻量化”解决方案

业界

一种轻松的上云方式,正成为众多海外跨境商家的新选择。2月16日,记者了解到,腾讯云轻量应用服务器Lighthouse针对跨境电商推出了“轻量化”解决方案,有效助力相应场景。海关数据显示,2021年我国跨境电商出口1.44万亿元,增长24.5%。疫情背景下,...

阅读更多