您现在的位置是:首页 > 业界业界

berttokenizer_earlmonroe球员厉害吗

![]() cc博主2024-03-16【业界】132人已围观

cc博主2024-03-16【业界】132人已围观

1、有 BertTokenizerFast 和 BertTokenizer, BertTokenizerFast 更快,因为使用了 tokenizer 库因为 tokenizer 库基于 RUST 所以多线程更好而 BertTokenizer 基于 python 的所以,我们使用 BertTokenizerFast from transformer。

2、情况是我用 add_tokens方法 添加自己的新词后,BertTokenizerfrom_pretrainedmodel一直处于加载中原因 有说是词典太大,耗时hours才加载出来我也没有真的等到过暂时的解决办法参考于。

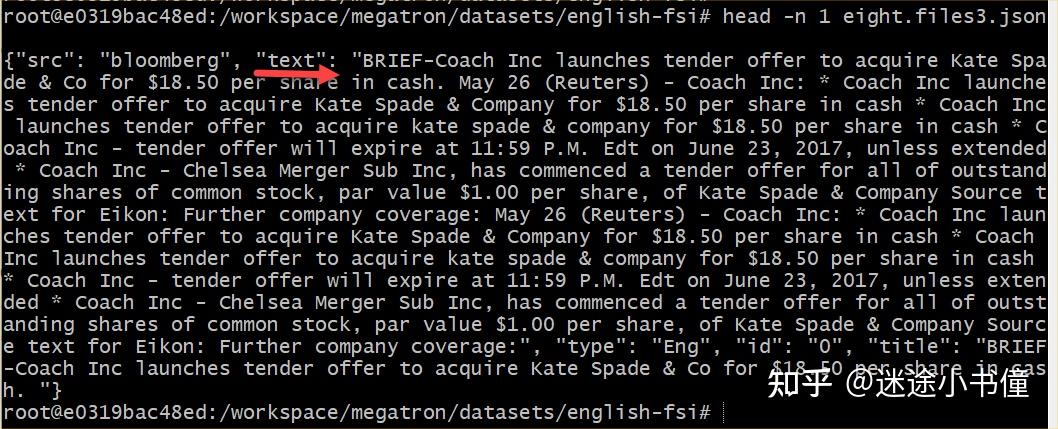

3、import torchfrom pytorch_pretrained_bert import BertTokenizer,BertModeltext0 = #39水果中很多对人有好处,比如苹果#39#句子0text1 = #39外国手机有很多都不错,比如苹果#39#句子1text2 = #39我喜欢在饭吃不同水果。

4、与NLP不同,语音信号是连续的,因此很难直接找到类似于BERT预训练的预测标签想要解决这个问题,就需要一个Tokenizer将连续的语音特征映射至离散的标签受文本预训练方法BERT的启发,语音表示学习模型HuBERT 2利用MFCC特征或。

5、frompytorch_pretrained_bertimportGPT2LMHeadModel,GPT2Tokenizer classPoemGeneratorobjectdef__init__self,model_path,device=#39cpu#39selfmodel=GPT2LMHeadModelfrom_pretrainedmodel_pathselftokenizer=GPT2。

6、同样的,输入是wordPiece tokenizer得到的 tokenid ,进入Bert预训练模型抽取丰富的文本特征得到 的输出向量,输出向量过 BiLSTM 从中提取实体识别所需的特征,得到 的向量,最终进入 CRF 层进行解码,计算最优的标注序列 N。

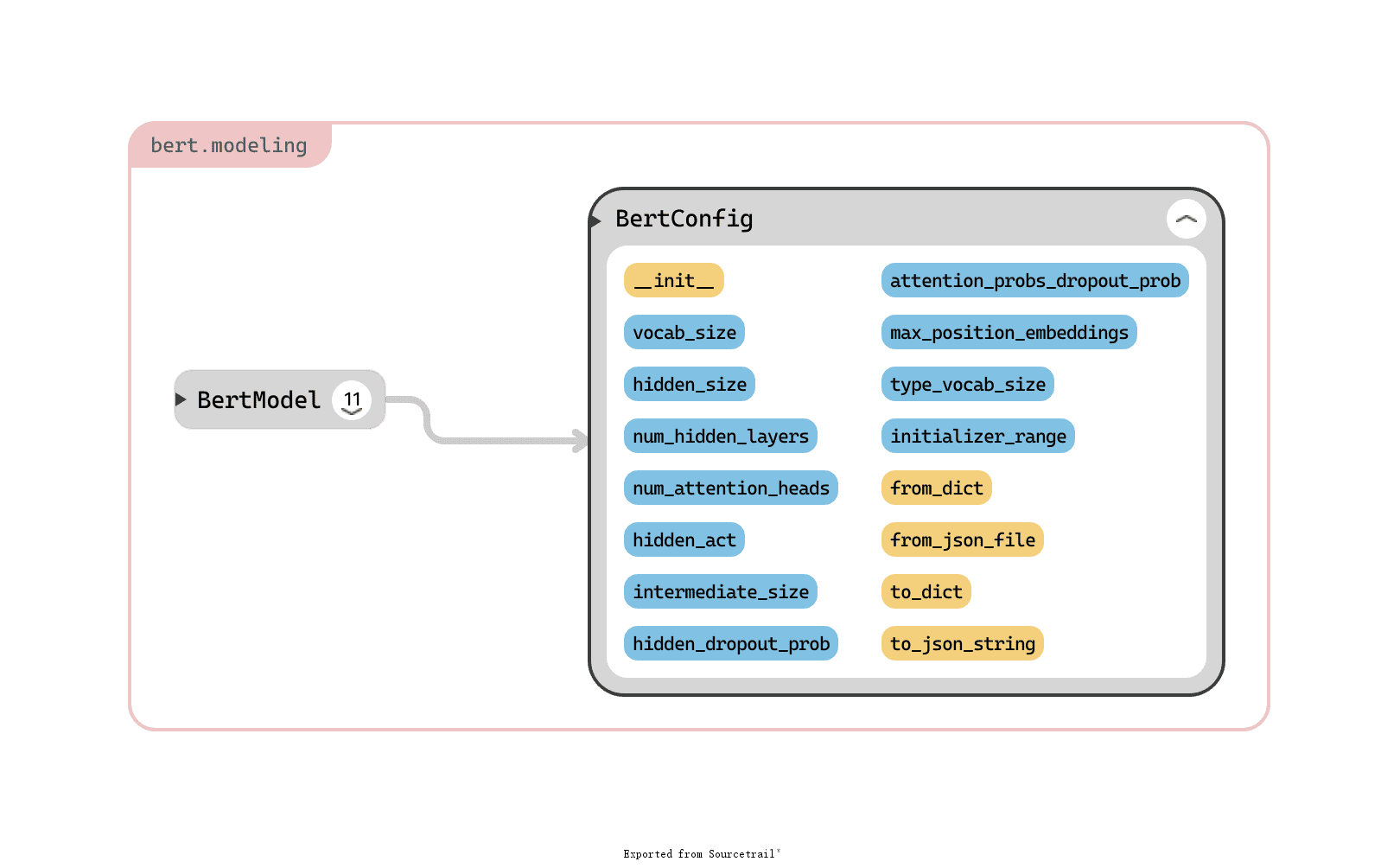

7、berttokenizer参数BERTTokenizer参数详解BERTTokenizer®HuggingFace公司提供的一个用于处理自然语言的Python库,它可以将文本序列转换为对应的token。

8、BertTokenizerfrom_pretrained ' bertbaseuncased ' 我们使用的是tensorflow,所以引入的是TFBertModel如果有使用pytorch的读者,可以直接引入。

Tags: